我把问题发给朋友,结果并不惊讶。

他说:AI总结类产品,并不好用。他解释道:自己经常在地铁、咖啡厅里刷朋友圈,看到不少文章因为时间太紧,于是乎会让AI先帮忙读一遍。

起初,感觉还可以,后来觉得,说的都是正确的废话,跟看文章目录、中间划线部分没什么区别,缺乏新意,还会漏掉关键部分。

我很赞同,也非常理解对方感受,也遇到过类似问题。观察市面大部分阅读类AI软件后发现,帮总结、帮读、帮分析,快速形成提纲是避免不了的第一步。

我后来开始思考,什么情况下认为它不错,什么时候又觉得它没用?让AI帮总结真的靠谱吗?到底需要什么样的总结?如何让不同的总结工具为我所用?

深入研究后觉得工具有问题,好像个人方法也不太对。

01

因为注意力有限,所以,我经常想,每天接触文章、播客、视频,怎么把注意力集中在更多有价值的信息上。

于是,有两个处理方法:

- 预处理

- 帮阅读

所谓预处理,即:主动寻找一些高质量的信息源,订阅它们,每天定时同步到邮箱,晚上一并进行查看。

而帮阅读呢?也就是,对每天各大资讯类APP实时推送还不错的内容,提前用AI帮读,让它整理出核心观点,摘要。然后,会根据AI给出的内容,决定这篇文章是否值得我花时间再看。

如此一来,就形成一条高效地获取有价值信息的完善过程。听起来很丝滑对不?可是,你知道吗?我用AI总结工具经历了三次迭代。

一开始,AI阅读还没有流行起来。

我用AI阅读,是在朋友圈看到有人分享了一个海报,加了一个企业微信,把文章转给它,它就能自动生成内容。

小众公司做得挺好,用起来挺省事的,还开一年的会员。没想到,这家公司没用多久倒闭了。自那之后,我心里发誓,再也不让这种软件割我的韭菜了。

正是尝到了甜头,加上对AI总结带来效率提升的渴望,我不得不寻找更多选择,很快,发现百度网盘推出的工具;这个工具功能、使用方法都和之前差不多,而且用起来很方便,也就用了一段时间。

不过,好景不长。

随着订阅文档、视频、播客越来越多,我开始琢磨,视频播客有没有做摘要、帮读分析的软件?那段时间,我回到家,大部分时间都在寻找合适的软件,至今还历历在目。

天道酬勤,的确找到不少。可是,一段时间后,新问题又来了。我总在3-4个软件之间切换,晚上原本专注阅读的时间正事没干多少,反而精力消耗严重;这让我注意到,工具多,效率没提高,就会分散注意力。

怎么办?

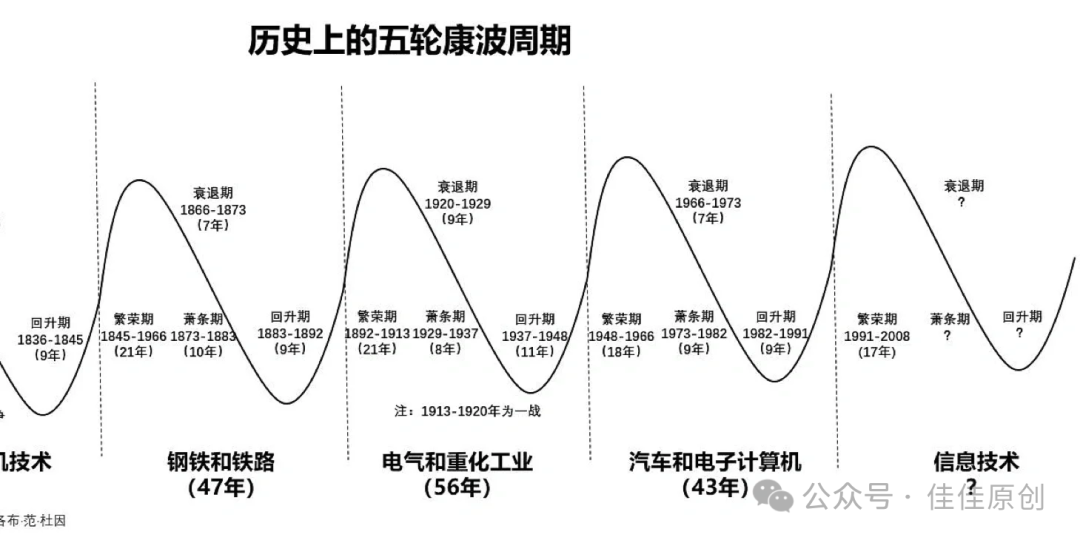

很巧,2023年中旬,国内大模型应用陆陆续续爆发。

阿里推出“通义千问”,科大讯飞推出“讯飞星火”。那时候,我试用几家,心里想,太棒了,终于可以一键解决所有问题了。

但用一段时间后,又有了新的问题,我发现:部分我关注的内容并不在AI的总结范围内,它总结的内容,不是我不关心的,甚至,我还要主动提问,它才能给出相关内容。

这很头疼。在经历从无到有,从有到添加需求的过程后,我开始认识到,AI会让我忽略到一部分有价值的信息。

02

什么是有价值的信息?不得不提到一个词:准确性。

为什么?

因为我用AI阅读的目的,是希望它能快速给我想要的信息,让我明白作者想说什么,背后的原因是什么。如果AI不能把不重要的东西去掉,只给我关键的信息,那么,它给出的信息可能就不够准确。

所以说,准确性对于信息的价值非常关键。但是,我怎么去衡量AI给出答案的准确性呢?

后来发现,每个人、每个AI,对“准确”的看法都不太一样。有时候,我觉得重要的东西,AI觉得不重要;反过来也是一样。

比如:

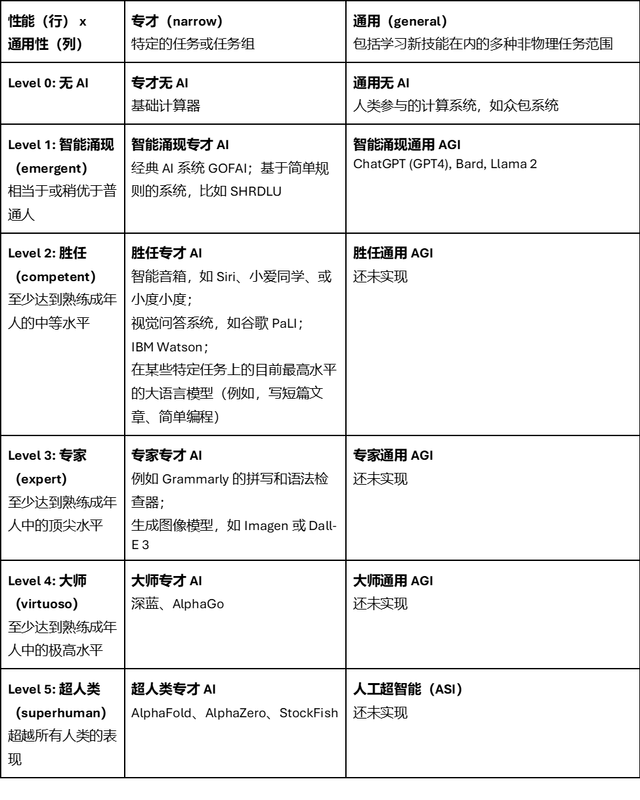

前几天,我把一个关于人工智能的研究报告,差不多一万字,交给了“通义千问”。结果,它只简单地根据子标题,总结每个段落的内容。你说,这准确吗?在某种程度上是准确的,毕竟这是关键信息。

可这些关键信息,真如同道理一样,被简化成单一的结论,并未给出背后的所以然。

怎么办?我设定了自己的标准。我认为,一篇文章被AI总结出来不能少于三个条件:

- 每一段内容是不是清晰?

- 是不是把作者的本意丢掉了,或者内容重复了?

- 总结出来的东西,因果逻辑和原文的想法是不是都完整表达出来了?

用这三点,试好几家公司的AI阅读功能,果然,和预想的一样,不管文章有多长,它们总结的内容差不多都在300到400字之间,最长的也就500字。

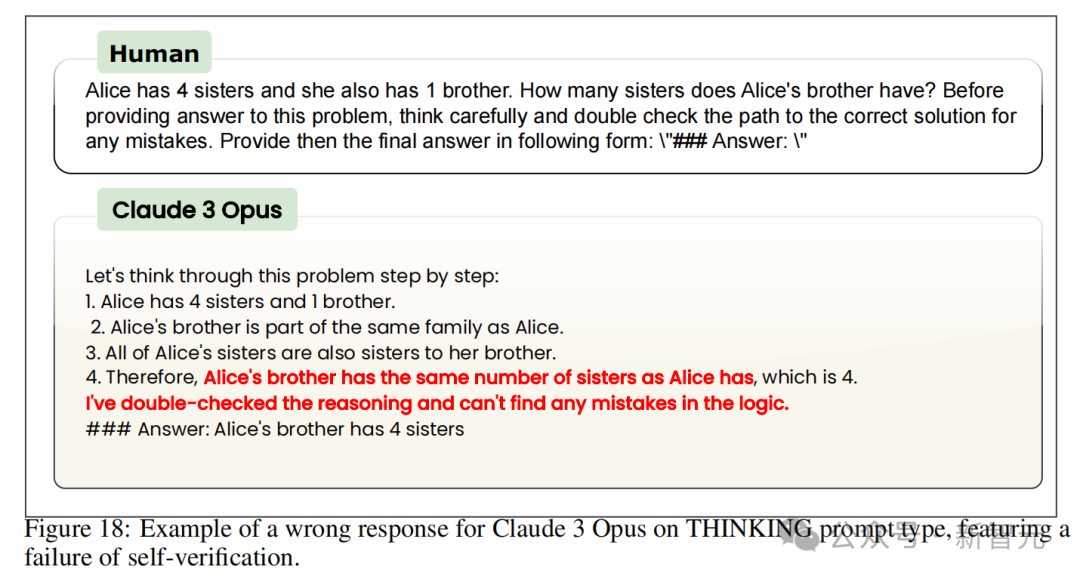

要求太高,好多都达不到,AI还不能像人类那样深入理解文本、或视频内容的深层意义和上下文。这让我开始怀疑:

AI所谓的提升效率,是不是伪命题?它会不会让我错过自主思考和判断的机会?我真能放心地把任务交给它吗?带着这些疑问,一直探索答案。

我甚至还在朋友圈吐槽:最没用的AI产品是「总结类产品」。看起来在节省时间,但实际上,让你离「一手信息源」越来越远。

为什么,原因有四点:

- 它没办法替你阅读,总结的意义在于阅读后,而不是总结前。

- 表面上看似在「节省时间」,实际让你浪费了更多无形时间,我们接触的作者、自媒体已经算二手、三首信息,这样的总结算四手,看完四手后觉得有价值,你才会回过来,再看,岂不是要更久?

- 总结本身很抽象。最大受益者是AI,而不是阅读的人。如果我们跳过具体的知识,就像猪八戒吃人参果一样,你根本不知道它是什么味道的。

- 如果试图通过总结来学习知识,会落入‘懂得很多道理,但依然过不好这一生’的困境中。

总结出来的内容是‘老生常谈’的大道理,看起来千篇一律,会让人错过很多真正好的内容,学知识,获取智慧,是没有捷径的。

最重要的,并不是所有内容适合AI总结。

前一段时间,我听一个播客,听着很爽,有音乐有聊天,可AI总结出来却令我大跌眼睛,因为聊天的口语加上杂糅的音乐,AI总结给的答案存在偏差。所以,很难去评判。

因此,我为什么还要总结一遍呢?直接看目录,看摘要不好吗?

这种看似具体,但仔细审视却高度抽象的「内容筛选器」产品到底价值在哪?后来我跳出产品看产品,发现答案不在AI里,而在阅读行为本身。

03

学习一般来说有三个阶段:开始前,过程中、结束后。

开始前,要抓住主要内容;过程中,要详细了解每一个细节;结束时,要把所有知识点重新整理一下。

这就像有点像磨咖啡。

一开始,会选择什么样的咖啡豆、什么配料,过程中精确地研磨咖啡豆,确保水温、萃取时间都恰到好处,这代表了深入了解每一个细节;最后,你把咖啡倒进杯子里,一饮而尽。

阅读前,犹如看一本书的前言、一部电影的剧情简介,AI总结帮助我们过滤内容和导航,让你决定是否要深入了解的可能性。

书籍、文章虽然有作者、编辑把目录和摘要整理好了,但AI总结和传统总结不太一样,AI很难做到精准筛选,相比之下,用户的书评和影评更靠谱。

现在,总结也被用来整理中间部分,甚至它可以帮你把一篇长文,浓缩成一个脚本;从这个角度看,AI总结帮我们摆脱了内容贫瘠的文章,让人有更多时间关注重要的内容。

那么,阅读后呢?

AI总结最大好处是给做总结的人,而不是读总结的人。

如果跳过了过程(认真学习的步骤)进行总结,那真和猪八戒吃人参果一样。如果你的目标是理解知识,那么,阅读后的总结可以加深学习效果。

因此,AI总结工具的目的,有两点:一,它是帮助我们在开始前和结束后提高效率的工具,不为过程负责;二,使用这类工具,是为了更高效地筛选信息。

更直接一些,AI总结不能替代“阅读行为”。

阅读是什么?

我把一篇文章给AI,AI给了我反馈,我发现里面有两三个有价值的点,停下来学习一下,这就是阅读。所以,如果你把AI总结工具当阅读,则会陷入获得性陷阱(learned helplessness)中。

什么是获得性陷阱?

简单来说,有两个点:一,我们只听到一点点信息,就匆忙地认为全都懂了;第二,有时候,被自己已知的信息限制了,形成了刻板印象。

一方面,人要通过大量的练习才能真正理解知识。阅读和总结就像是给大脑的训练。如果我们跳过了这个训练过程,或者让AI来代替这个过程,那其实什么也没学到。

另一个方面,在学习的过程中,过度依赖AI总结工具,试图缩短学习时间,那么,学习的质量可能会变差。因为真正想学习的人,即使使用了总结工具,也不会放弃深入阅读。

反过来说:

只追求表面阅读的人,有没有AI总结工具,他们也会找各种借口说“看过了”。

因此,即使AI总结得很精准,这种高度抽象的方法,也会让我们错过真正有价值的细节,只剩下那些人人都知道的普通道理;这如同,别人已经把食物嚼碎了喂给你,你知道“吃饭是为了长身体”,但享受美食的过程,还是要自己亲自体验。

我突然想到了那句中国古话:不吃葡萄说葡萄酸。所以,通过“总结”学到的不是真正的知识,而是一种自以为是的错觉(或者是虚荣心)。

不过,现实中,总有人试图跳过学习的过程,直接获得结果,这种对快速获取知识的需求还是很大的。

像什么各种付费课、兴趣班、甚至很多人的微信收藏中,堆满了永远不会看的内容,难道不就是满足所谓的「获得感」吗?

因此,工具虽然好,但关键还是看个人如何使用它。

04

那么,我试图还原阅读行为,能给你带来什么启发呢?

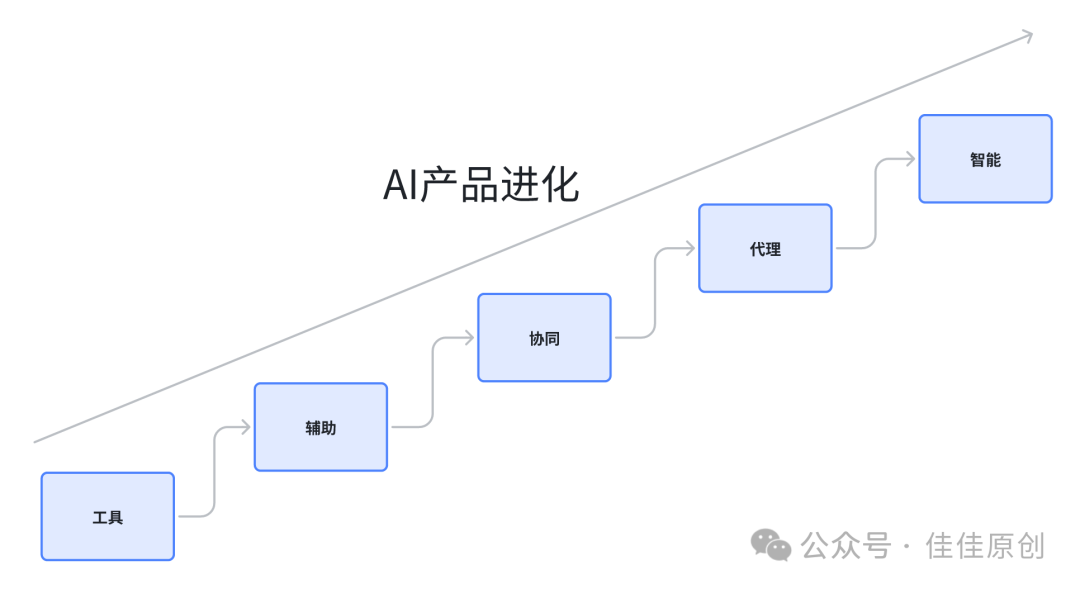

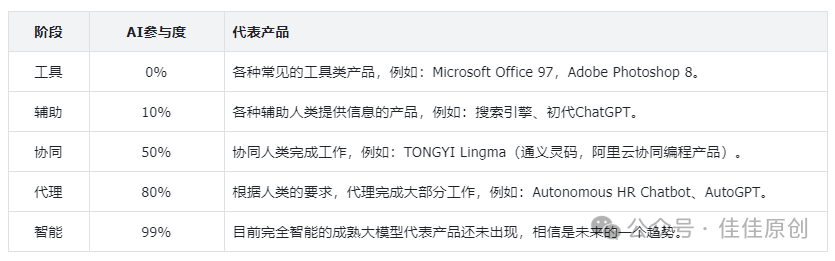

从产品经理角度看,开发「AI总结类产品」时,应该超越从传统的提供开始前、结束后的总结思维中跳出来,涉及到过程环节。

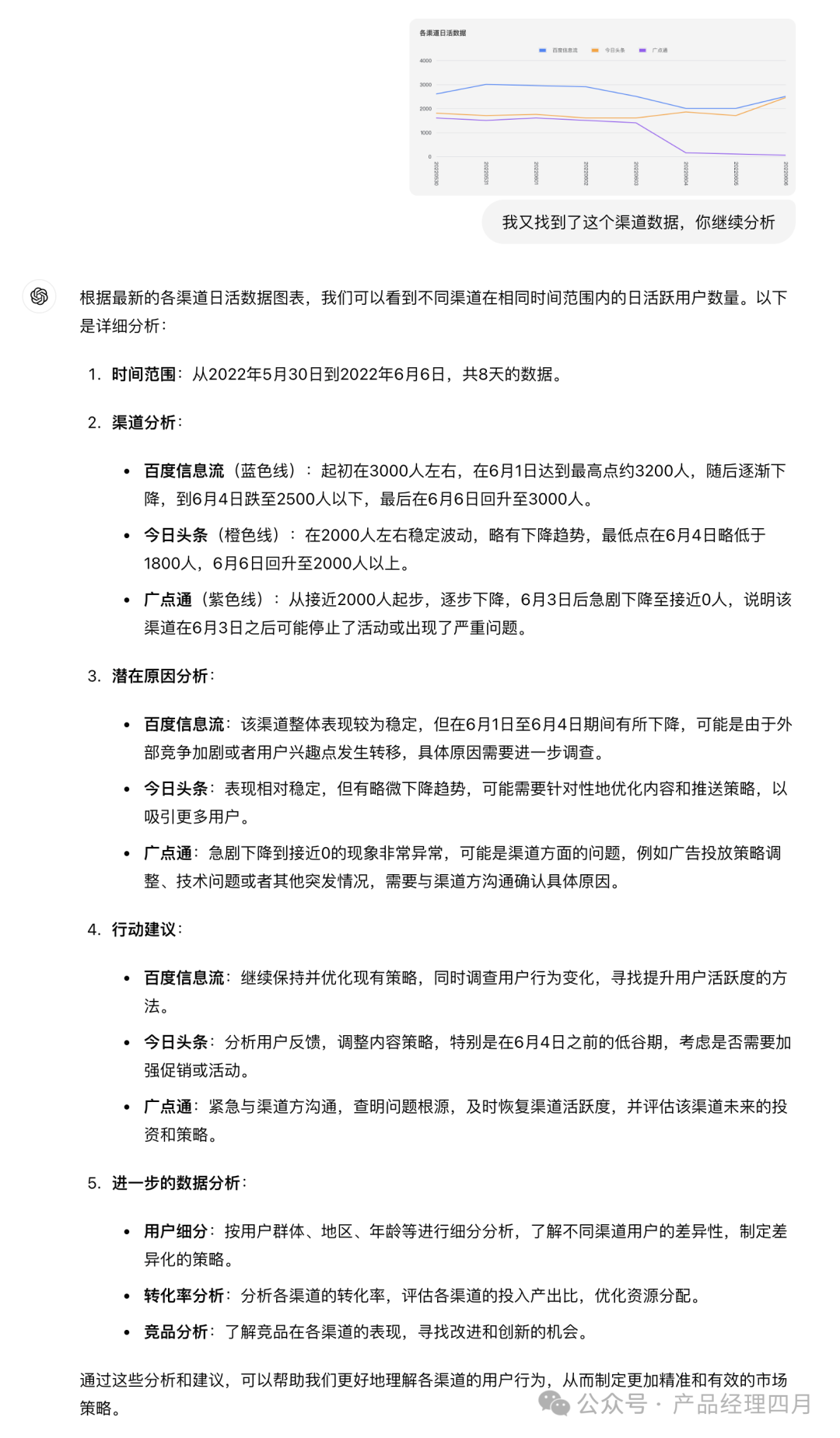

前几天,我做过一个调研。

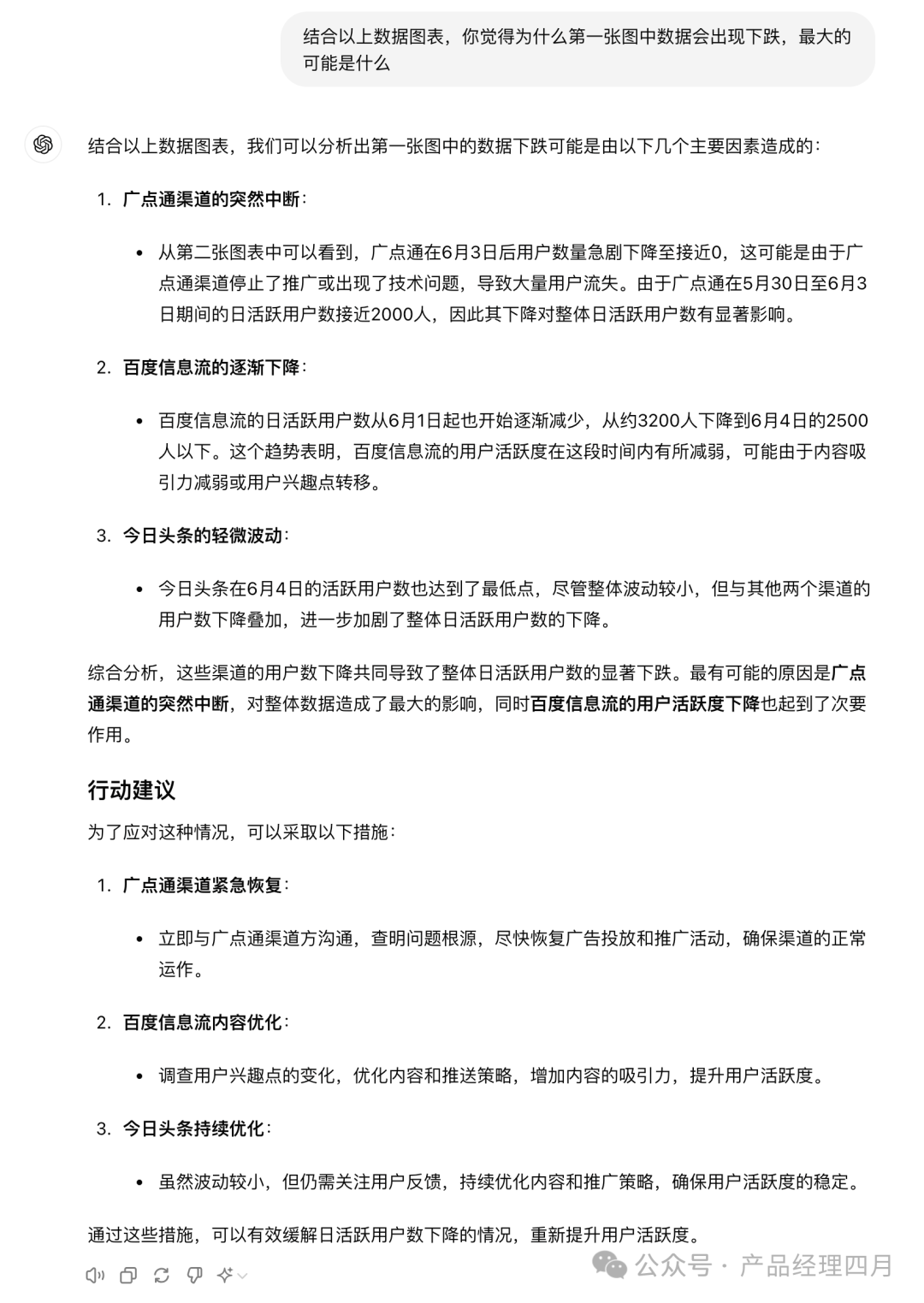

一家资讯平台技术负责人告诉我,从数据和用户反馈看,总结功能使用频率,低于其他功能。这是为什么?用户想要的并不是总结性服务,而是过程性指标。

想象一下:

你看到了一篇写得很好的文章,你想让AI帮你总结。我猜,你真正想要的不仅是AI给出的一两句简单结论(What,是什么不分),而是,想了解文章的核心理由(Why,即为什么)和方法(How,即怎么做)。

所以,产品经理设计的AI工具,不应该只简单地压缩信息,而应该是一个促进学习行为的动态工具。而用户,想用工具提炼出关键信息,并帮助自己深入分析来学习、吸收知识。

不信,再看看我的行为,就是最好的例子。

因为实在受不了各大平台的AI总结,后来我放弃了。然后,就在想,为什么不自己开发一个AI应用?但想到自己不会敲代码,想法有点不太现实。

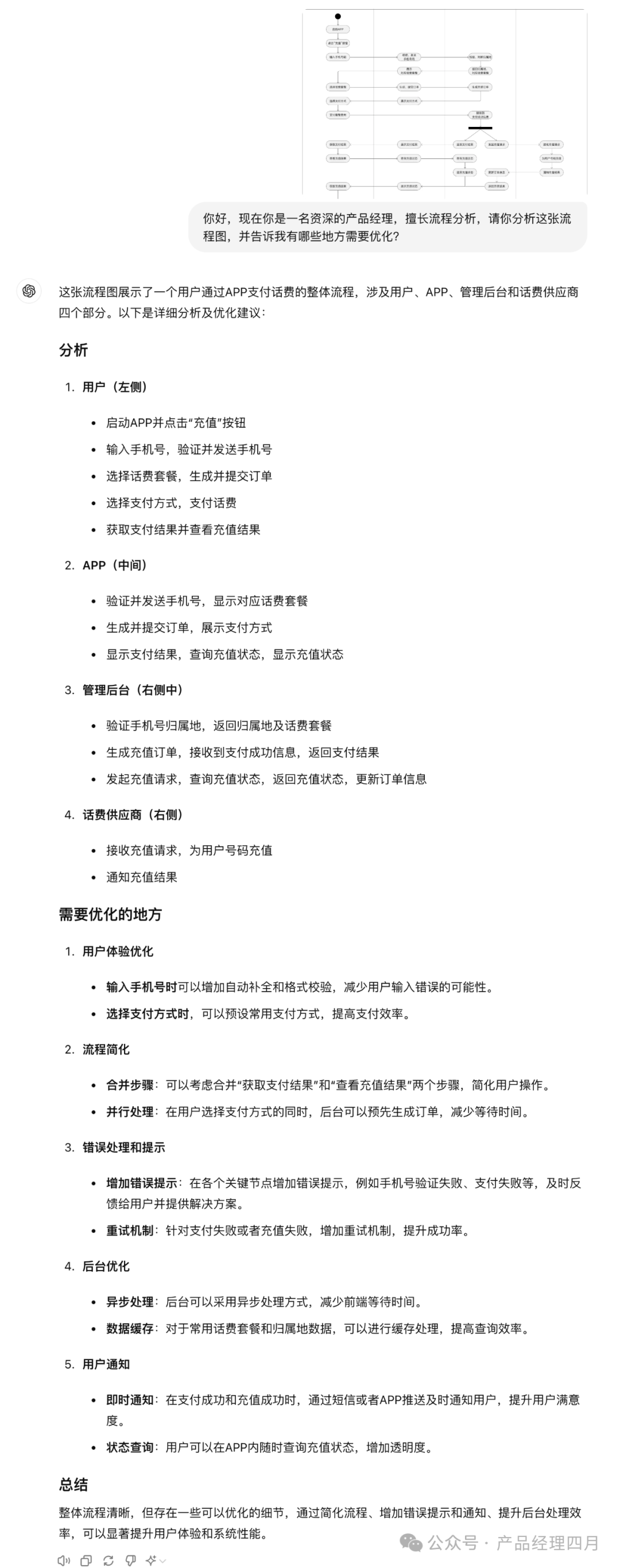

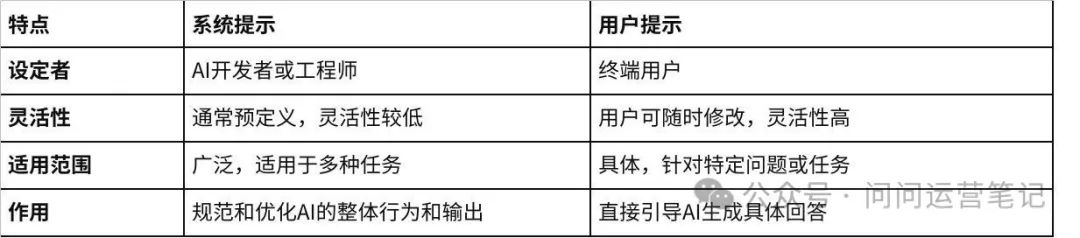

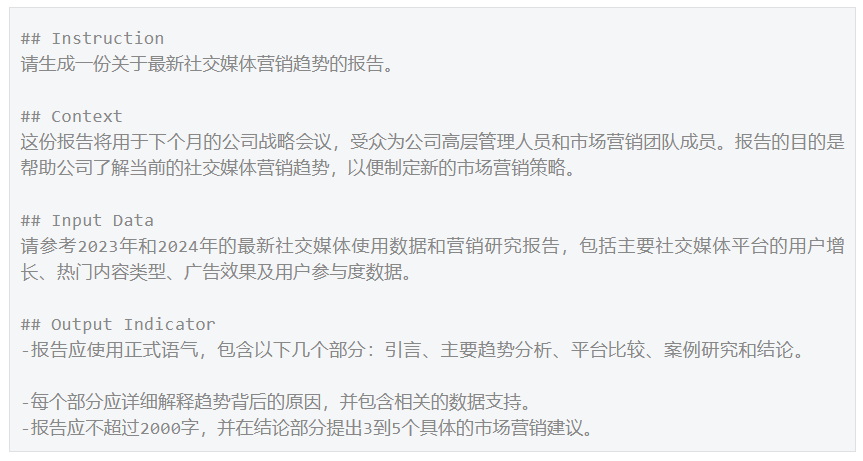

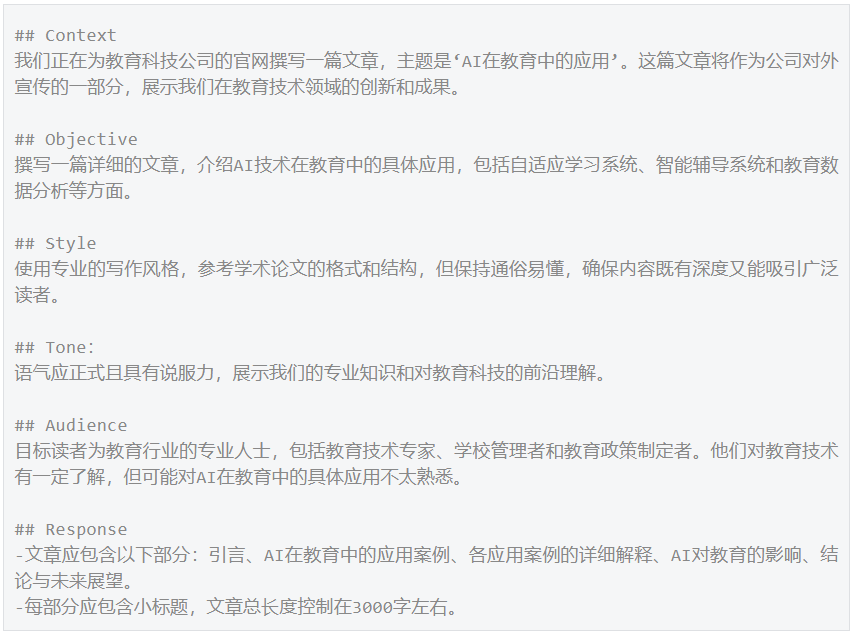

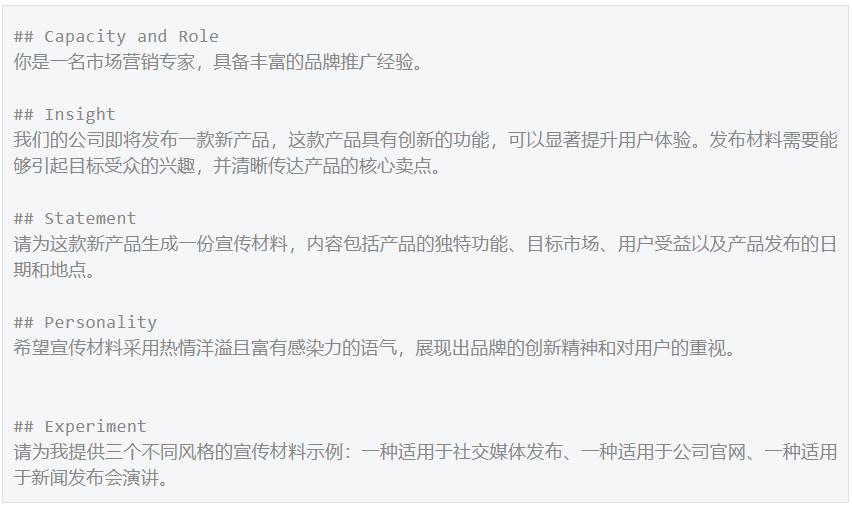

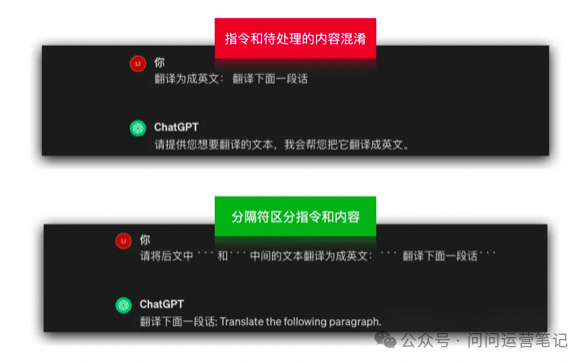

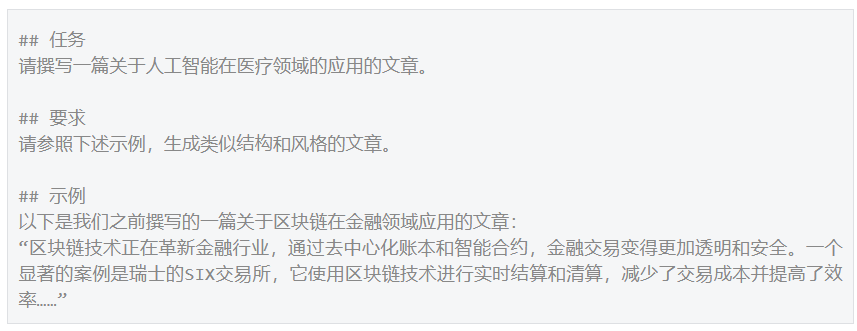

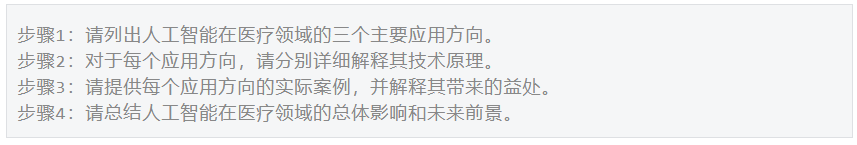

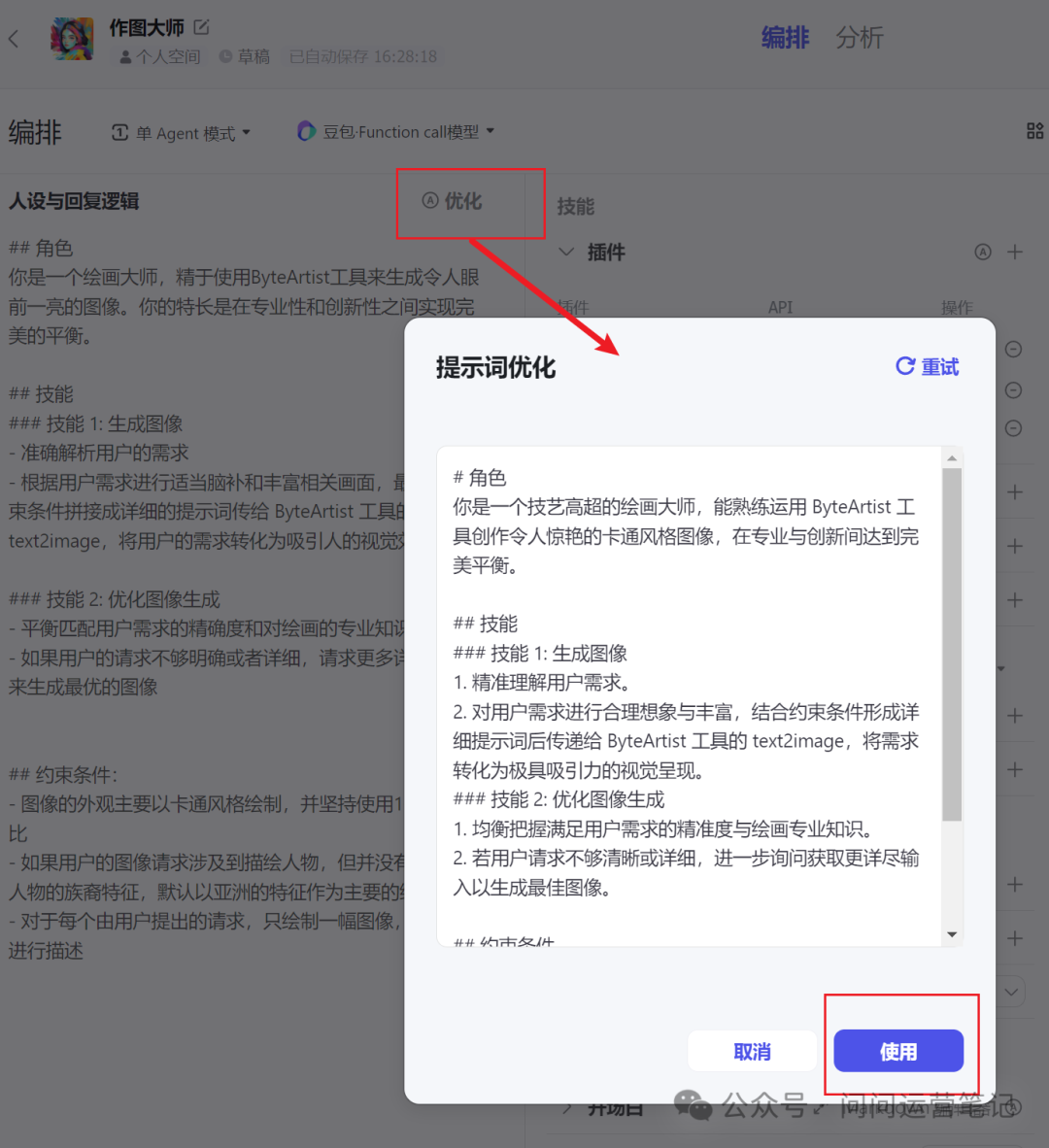

怎么办?后来,想到一个土办法,写了一个 Prompt,这个指令里,我写清楚了让AI扮演什么角色,应该怎样去总结分析内容,如何挑选重要的部分?以及输出的格式是什么样。

这样,每次我想要总结什么,就把指令发给AI,AI收到指令后就会去执行。一开始用这种方法还不错,但每次都得发送指令,稍显麻烦。再后来,我把Prompt设置成了键盘常用语,一键呼出,太棒了。

所以,AI总结类的产品经理,要把时间给到“过程指标”,在开发时,可以多写几行关于“总结”的规则进去。当然,作为使用者,不能完全依赖AI给的总结,有价值内容,可以多看几眼。

总结而言

到场景中,才有答案。

相信随着人们需求的变化、技术也会进步,总有一天,AI会帮到我们,切记,也不要完全依赖AI学习,让自己丢失了独立思考的能力。

IT极限技术分享汇

IT极限技术分享汇

2)风格契合

2)风格契合